从“可用”到“好用”:如何跨越大模型落地鸿沟?

当前,虽然随着技术的快速更迭,大语言模型已在通用任务或特定基准测试中展现出卓越性能,但客观来看,大模型在财务领域中的应用,仍然处于技术成熟的早期阶段,仍然面临幻觉待控、结果难追溯、复杂财务场景难落地等问题。从“可用”到“好用”之间,仍然横亘着漫长的“鸿沟”。

那么,企业该如何跨越这道鸿沟,破解当前大模型财务应用难题呢?基于当前的现实背景,我们有四点建议。

场景选择:优先选择简单、有效的场景,规避风险和收益失衡的场景

当前,大模型并非在所有的财务场景都有落地能力和落地价值,企业需要从当下技术成熟度与自身实际需求之间取得平衡,寻找适配自身业务场景的“动态”最优解。

结合企业自身的业务需求,我们将大模型潜在的应用场景按“可行性”和“价值度”两个维度,分为“简单有效”“技术复杂”“存在风险”“收益不足”四类。具体如图1所示。

图1 大模型在财务场景应用的选择优先级

Ⅰ类场景的核心特征是“流程链条短、技术架构简单、实施成功概率高”。这些都是当前大模型擅长的领域,技术成熟度高,能让企业快速看到效果,因此企业可优先选择。主要有以下典型的场景:

(1)非结构化图片、文档、文本处理。举例而言,具有进出口业务的企业,每月会收到大量来自不同国家的票据——英文的酒店账单、法文的火车票、印尼的高速公路收费单,这些票据版式各异、语言不同,人工识别不仅效率低,且极容易出错。而大模型的多模态理解能力和语言能力等,能帮助财务人员快速提取这些非结构化数据所蕴含的关键信息,大幅提升财务人员的工作效率。

(2)基于自然语言规则的附件审核。主要是利用审单对单据和单据的附件信息进行解读,搭配自然语言审核规则,对业务过程中的相关单据和单据附件进行审核。比如在费用报销审核场景中,针对“报销附件是否符合制度要求”,大模型可以根据自然语言描述的规则,先理解《费用报销管理制度》中的审核规则,再自动识别附件内容,对其存在性和内容合规性进行审核,以此判断是否符合要求。

(3)系统操作答疑和工单处理的智能客服。这类场景往往文档结构清晰,知识相关性少,检索容易,因此成功率也极高。比如面对功能复杂的财务系统,有些企业新员工往往需要反复咨询“如何生成付款单”等这类问题。企业可以通过大模型构建智能客服,将系统操作手册、常见问题整理成知识片段,以供员工随时咨询获取答案。

Ⅱ类场景主要是一些技术复杂度较高的场景。此类场景高度依赖模型、工具能力和工程化方法的综合应用。以智能问答场景为例,它需要先对用户的自然语言提问进行实体识别与句法结构分析,精准处理数据查询意图;再依托数据中台,通过数据表推荐、权限过滤、数据库方言适配等环节生成查询语句;最终还要对查询结果进行审核、文字摘要生成与图表生成等加工,整个过程不仅需要大模型在自然语言理解、复杂业务逻辑推理等方面的能力,也需要小模型(专业AI算法)在数据库指令适配、可视化结果生成等专项任务上的精准执行,同时离不开元数据治理、数据中台等数据基础建设的支撑。此部分业务场景想要取得较好的场景落地效果,往往需要较大的投入,企业可结合企业自身情况选择投入。

第Ⅲ类场景则主要集中在当前大模型技术度能力不足、不擅长的领域,如智能决策、战略规划等场景,此类场景目前仍处于探索性阶段,失败概率较高,落地效果难以保障,企业需谨慎评估。Ⅳ类场景则属目前投入“收益不足”场景,需避免盲目投入。

AI是方向,人类仍是关键齿轮

从当前大模型技术在企业的具体应用场景来看,仍是以人机协同为主——这本质上是技术成熟度与场景需求平衡的结果:当前,大模型的幻觉率尚未完全可控、企业私有知识与系统的适配仍需打磨,因此人机协同成为风险最低、效果最稳定的选择。当前人机协同主要有五种模式——指令协同、流程协同、事件协同、定时协同、异常协同,在不同的财务场景中都有具体应用。

(1)指令协同。财务人员发出指令,大模型响应执行。

(2)流程协同。数字员工作为工作流程上某个环节的处理人,独立完成特定任务,提交给人复核。

(3)事件协同。人类员工设定特定事件,触发数字员工的工作任务,比如设置“当应收账款账期超过90天时,大模型自动生成催款函并发送给客户”。

(4)定时协同。人类员工设置定时任务,由数字员工自动执行。比如设置“每月最后一天,大模型自动汇总各部门费用执行情况,生成费用分析报告”。

(5)异常协同。当数字员工执行任务遇到异常时,主动请求人类员工介入。异常协同是应对大模型能力边界的关键。大模型并非万能,遇到“模糊的手写票据”“复杂的税务政策解读”等情况时,可能无法准确处理。此时,大模型会主动将问题转交给财务人员,待人员处理后,再继续执行后续任务。这种方式既保证了流程效率,又避免了因大模型误判导致的风险。

关注应用治理,让大模型规范运行

大模型应用不是“一劳永逸”,还需要持续地治理与管控。除了控制好场景开发流程外,企业应用治理应重点关注以下内容:

第一,关注智能体交互的输入输出内容,对非结构化数据与结构化数据进行全生命周期管理,确保数据在交互过程中的安全性、完整性,防范数据泄露、篡改等风险,同时严格符合数据隐私保护与财税、审计等行业合规要求。

第二,详细记录智能体执行的规则、算法,推理决策的过程,调用的工具等行为,确保过程留痕可审计,既满足财务审计“可追溯、可验证”的核心要求,也为大模型后续迭代优化提供真实有效的行为数据依据。

第三,关注智能体的功能权限和数据权限控制,明确大模型在财务场景中“能执行什么操作”与“能访问什么数据”。

幻觉控制:无法完全消除,但可有效管控

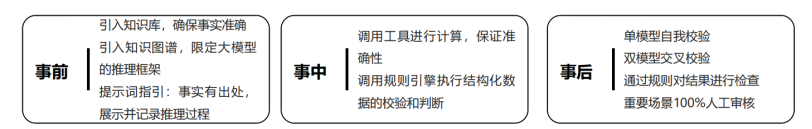

幻觉是大模型的概率算法先天决定的,无法避免。但如图2所示,企业可以通过事前、事中、事后三个阶段进行控制。

图2 从事前、事中、事后三个阶段控制大模型幻觉

事前控制的核心是“给大模型提供准确的‘养料’”,限定大模型的回答范围,避免其凭空编造。这种“养料”可以为特定的知识库,也可以为不同类型的知识图谱,以结构化的实体-关系网络(如业务中的组织架构、流程关联、数据逻辑等)限定大模型的推理边界与逻辑路径。此外,在提问时,也可以通过提示词指引,设计能引导大模型为事实标注明确出处,并分步展示、记录推理过程的指令,既提升输出的可信度,也为后续校验留存追溯依据。

事中则是“让大模型克服自身的局限性,学会‘求助’工具”。比如,当大模型涉及数学运算、精准数据查询任务时,可自动触发后台计算引擎或API,以工具的确定性精准计算替代模型概率生成的不确定性,保障数值类输出的准确性。或者通过调用预设的规则引擎,执行结构化数据的校验和逻辑性判断,实时检查大模型处理后的数据是否符合格式、逻辑要求,有效避免大模型的主观臆断风险。

事后控制则是最后一道防线,可通过多维度校验确保结果正确。首先,既可以通过单模型自我校验,借助模型自身能力发现潜在问题,也可以通过双模型交叉校验,对同一问题生成结果,通过对比不同模型的输出来挑刺。其次,通过固定规则对结果进行核查,以行业规范、企业制度等明确规则为“标尺”,逐一核验大模型输出是否符合。最后,针对核心业务决策、敏感信息发布等重要场景,安排专业人员100%人工审核大模型的输出结果,以人类专业判断和经验彻底过滤幻觉错误,确保结果高度可靠。

*本文改编自《管理会计研究》杂志2025年第6期(总第45期)数智化经营栏目

*本文由《管理会计研究》杂志授权刊登

......